AI大模型的“幻觉”是指其在生成内容时可能出现不符合事实或逻辑的错误信息。

由于AI是基于概率生成文本,而非真正理解和推理,因此它可能会创造看似合理但实际上并不存在的内容。例如,AI可能会捏造一位从未存在的历史人物,并提供详细的生平背景,甚至伪造相关的事件和日期。

这种问题在学术、法律、医学等领域尤其值得关注,因为错误的信息可能会误导研究人员、法律从业者或患者,导致严重后果。此外,AI幻觉还可能影响商业决策,比如在市场分析或财务预测时提供错误的趋势信息,进而导致企业做出错误的投资判断。

这种幻觉现象不仅影响AI的可信度,还可能对社会产生更广泛的负面影响。许多用户习惯于依赖AI进行信息查询,而未能对内容进行严格核查。如果AI生成的错误信息被大范围传播,可能会引发误解,甚至形成公众认知偏差。例如,在新闻传播领域,如果AI生成的不实信息未经核实就被广泛引用,可能会加剧虚假信息的扩散。因此,理解AI幻觉的成因,并采取有效措施加以规避,对于确保AI的安全性和可靠性至关重要。

在客服领域,则有可能会导致客户获取错误的信息或方案,轻则导致客户投诉,严重者还可能引发法律诉讼风险。

1. 数据问题AI模型的训练高度依赖于大规模数据,而这些数据可能并不总是准确或完整。在互联网上,信息的来源复杂多样,其中不乏错误、过时、偏见甚至虚假内容。AI在训练过程中会学习这些数据的模式,但无法自动辨别哪些信息是可信的,哪些是不准确的。例如,如果AI的训练数据包含错误的历史事件或伪科学理论,它就有可能在回答相关问题时提供错误的内容。此外,数据覆盖范围的不均衡也会导致AI幻觉的产生,例如某些领域的数据量较少,AI可能会基于有限的信息做出错误推测。

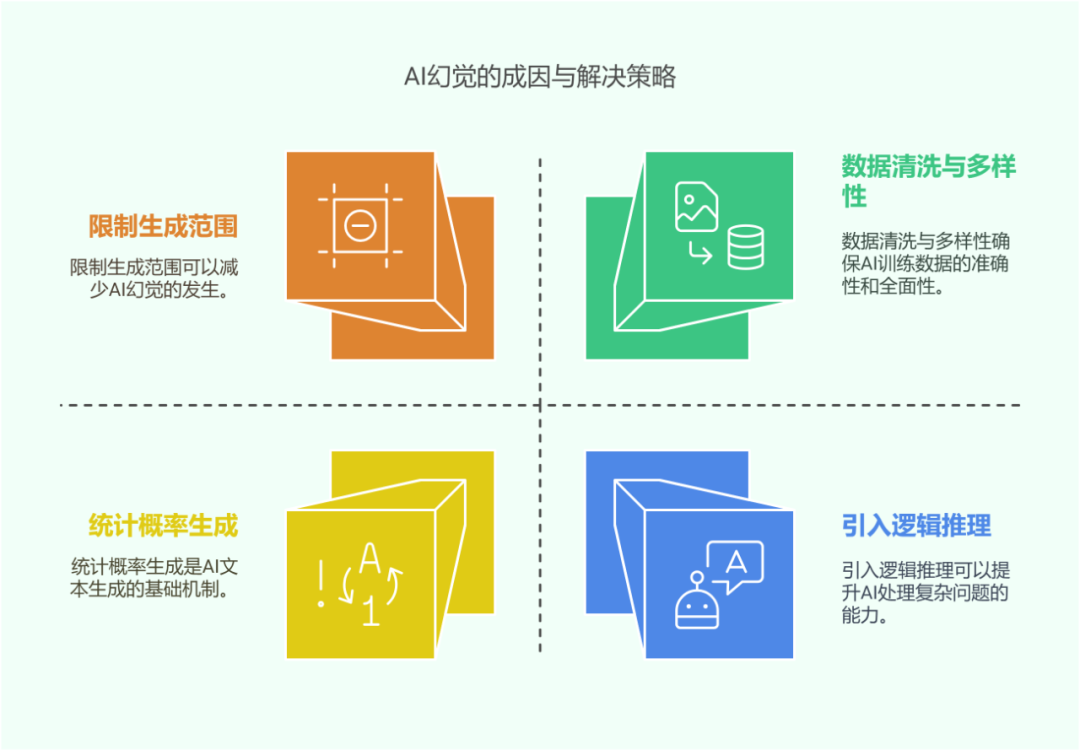

2. 模型限制AI虽然具备强大的语言生成能力,但本质上仍是基于统计概率进行文本预测,而非真正的逻辑推理。它的工作方式是根据上下文预测最可能出现的单词或句子,而不是像人类一样进行因果分析。例如,在回答某个复杂的科学问题时,AI可能会选择一个“听起来合理”的答案,而不是严格遵循事实和逻辑推理过程。尤其是在涉及跨领域知识整合时,AI的能力可能受限,导致生成的信息缺乏一致性,甚至相互矛盾。此外,AI无法真正理解抽象概念,因此在哲学、伦理学等领域的回答可能会显得混乱或缺乏深度。

3. 生成机制AI的文本生成依赖于神经网络的深度学习,而这种学习方式主要基于概率模型,而非逻辑推理。例如,当AI回答一个医学问题时,它并不会像医生那样基于解剖学、生理学等知识进行系统分析,而是根据训练数据中出现的模式进行预测。这种方式在很多情况下能提供有用的信息,但当AI遇到缺乏充分训练数据的问题时,它可能会填补空白,编造看似合理但并无依据的内容。此外,AI在长文本生成过程中可能会“走偏”,即随着生成的内容增多,它可能会逐渐偏离原始主题,导致信息的不准确性增加。

1. 提高数据质量

数据清洗:确保AI训练数据的准确性是减少幻觉问题的关键步骤。在数据预处理中,需要对训练数据进行严格筛选,去除明显的错误信息、过时内容以及带有偏见的数据。例如,在法律领域,确保AI学习的是最新、权威的法律条文,而非来源不明的网络解释,可以极大减少AI提供错误法律咨询的风险。同时,数据清洗还涉及去除重复信息,避免AI在回答问题时提供过时或错误的答案。此外,使用更严格的标注和数据分类方法,可以确保AI对不同领域的信息进行更准确的处理和学习。

数据多样性:为了减少偏见并提高信息的准确性,AI需要从多个独立来源获取数据,而不是仅依赖单一的信息来源。例如,在医学研究中,训练数据应包括来自多个国家、不同机构和多种语言的医疗文献,而不是仅仅基于某个特定地区的研究成果。这样可以减少由于数据单一性导致的错误推测,提高AI对不同文化、语言和背景信息的理解能力。此外,建立更全面的知识图谱,让AI能够更精准地关联不同领域的信息,也能降低幻觉的发生概率。

2. 优化模型设计

引入逻辑推理:在AI大模型中引入逻辑推理模块,可以提升其在复杂问题上的准确性。例如,结合符号推理和知识图谱,使AI不仅能够基于统计概率生成文本,还能进行逻辑验证。例如,在回答数学问题时,AI可以先进行计算,然后验证计算结果是否合理,而不是单纯依赖训练数据中的模式。此外,开发更强的推理能力,使AI能在回答因果关系问题时进行更深层次的分析,有助于减少因推测错误而导致的幻觉问题。

限制生成范围:通过设定AI的生成边界,可以减少幻觉的发生。例如,在回答科学或医学问题时,AI可以优先引用权威期刊或政府机构的数据,而不是基于普通的网络信息进行回答。此外,AI可以在遇到不确定性较高的问题时主动提示用户,例如“该问题存在多个不同观点”或“当前数据不足以提供确切答案”。这样的方式可以增强AI的透明度,让用户对信息的可靠性有更清晰的认识。

3. 加强用户反馈

用户纠错机制:建立用户反馈系统,让用户能够对AI生成的错误信息进行标注,有助于持续改进AI的回答质量。例如,当用户发现AI提供的历史事件信息有误时,他们可以提交更正建议,而这些反馈可以被用于训练下一代AI模型,减少类似错误的发生。此外,用户反馈系统还可以帮助识别AI在特定领域的弱点,为后续优化提供方向。

持续学习:AI模型可以利用用户反馈进行持续优化,通过机器学习不断调整自身的回答策略。例如,在金融分析领域,AI可以通过分析用户对其预测结果的反馈,调整其预测模型,从而提高金融数据分析的精准度。同时,结合专家审核,让专业人士参与到AI训练过程中,确保AI的学习方向更加准确和可信。

随着人工智能技术的进步,AI幻觉问题预计将得到进一步缓解。技术层面,更多的逻辑推理、知识图谱整合以及事实核查技术将被引入,以提升AI的真实性和可信度。用户层面,提升公众对AI幻觉问题的认知,使用户在使用AI生成内容时保持批判性思维,可以降低误导的可能性。此外,随着法规和道德规范的完善,AI的使用将受到更严格的监督,以确保其在提供信息时更加可靠和负责任。

尽管AI大模型的幻觉问题仍然存在,但通过数据优化、模型改进、用户反馈和外部验证等方式,可以大幅减少AI生成错误信息的可能性。未来,AI的发展不仅依赖于技术突破,也需要研究者、开发者和用户的共同努力,推动AI朝着更安全、更精准、更负责任的方向发展。

-END-