头戴式显示器(HMDs) 正逐渐融入我们的日常生活,从医学到娱乐各个领域,XR设备的应用越来越广泛。然而,与传统的键盘和鼠标相比,HMDs缺乏统一的交互标准。

目前的设备多采用手持控制器、语音和手势等多种交互方式,但这些方式在某些场景下并不理想,例如在嘈杂的环境中或人多的公共场所。相比之下,眼动追踪和凝视交互可以通过捕捉用户的视线,提供直观、快速且隐蔽的交互方式。

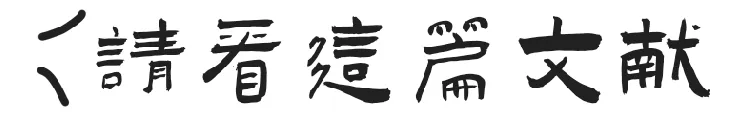

研究将凝视交互分为 三个主要方向 :显式凝视交互、隐式凝视交互(自适应和专注用户界面)、以及协作性凝视交互。

*相关研究文献部分合集在文章末尾

类似于计算机上的鼠标,用户可以通过凝视来选择目标对象或触发操作。

常见的技术包括“凝视停留”方法,即通过在目标上凝视一定时间触发选择,但这种方式有时会导致疲劳。

为此,研究者还探索了其他替代方案,如眼球手势和半眨眼输入,来提高交互的效率和准确性。

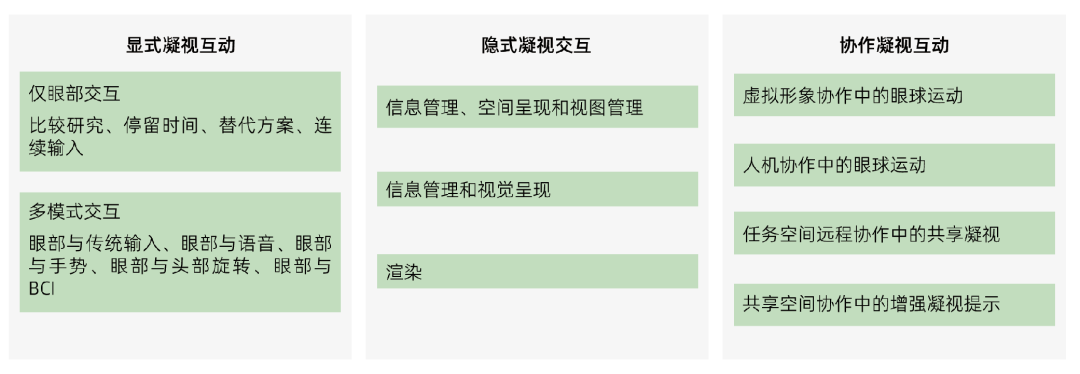

1)VR 中的目光注视打字 [1]

2)虚拟现实中通过平滑的眼球追踪运动进行选择 [2]

3)焦深作为增强现实中的交互方法 [3]

4)增强现实中的目光适应性注释 [4]

5)结合目光注视和头部旋转来选择物体 [5]

6)目光交互与智能手表输入相结合,作为 AR 中的注释系统 [6]

7)凝视与徒手手势相结合,用于在 VR 中选择和操作物体 [7]

这类交互通过实时分析用户的视线,动态调整系统参数,进而优化用户体验。

例如,系统可以根据用户的凝视方向调整虚拟信息的位置,避免重要内容被遮挡。这类技术常用于减少信息过载,提高界面的智能性,使XR设备成为“无所不在的增强现实”。

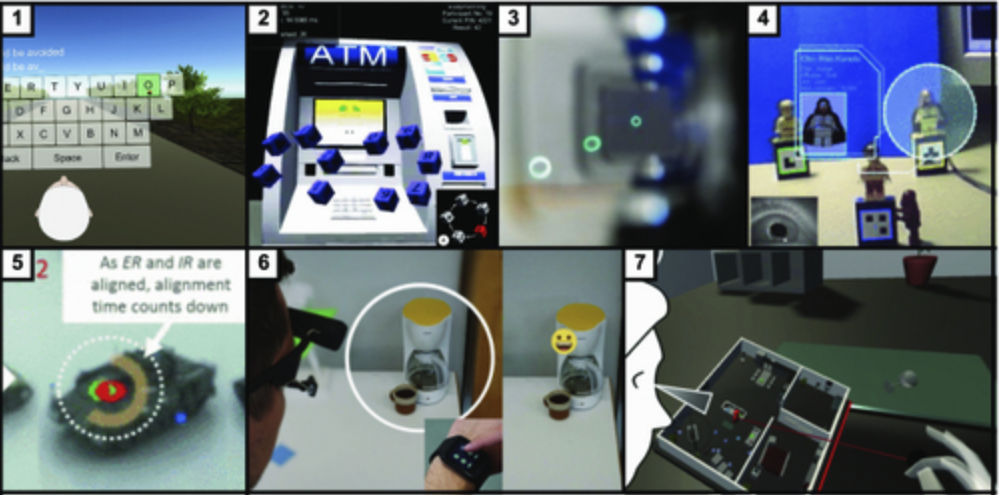

a)根据用户的注视管理标签放置 [8]

b)根据用户的焦距调整虚拟内容的可见性 [9]

c)从自我中心视角预测活动和工作量 [10]

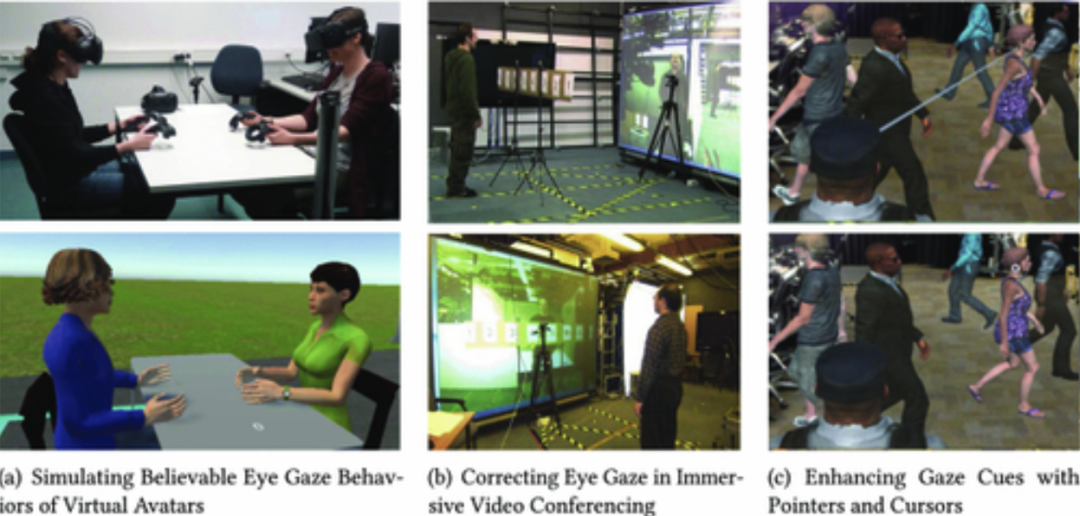

在远程协作或多人互动中,眼动追踪可以显著提升沟通效率。

例如,在虚拟环境中,捕捉用户的视线并将其映射到虚拟化身的眼部动作上,可以增强互动的真实性。同时,智能虚拟助手也可以利用眼动信息来调整其行为,使互动更加自然和顺畅。

a)开发虚拟现实中虚拟形象介导通信过程中真实眼球注视的眼球行为模型 [11]

b)在沉浸式视频会议环境中使用眼动仪校正注视方向 [12]

c)在协作环境中使用指针和光标增强共享注视线索 [13]

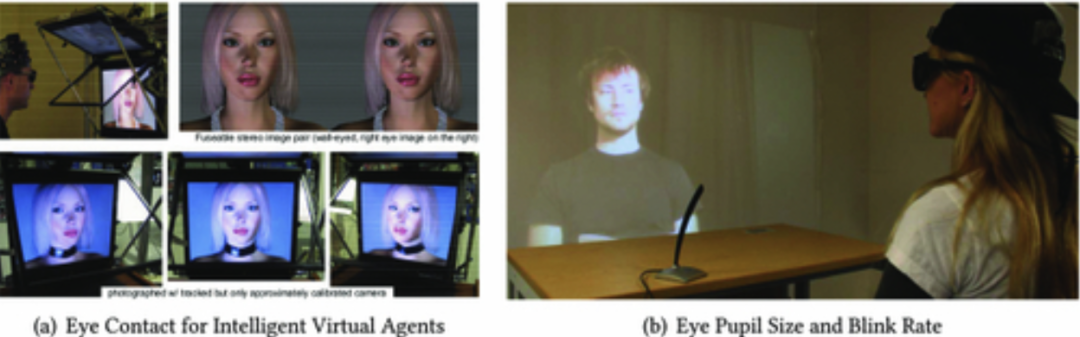

a)模拟交互式虚拟角色与真实用户之间可信的目光接触 [14]

b)整合瞳孔大小和眨眼率跟踪,例如,表明此类目光线索可实现比视频会议更高的测谎率 [15]

在研究头戴式扩展现实(XR)设备中凝视交互和眼球追踪的过程中,实验设计通常包括以下几个关键步骤:

实验首先需要选定合适的HMD设备,如HTC Vive、MagicLeap One或Microsoft HoloLens等,这些设备大多内置眼动追踪功能或可以外接眼动追踪模块。实验环境也需要精心布置,以确保实验条件的可控性,例如固定光源、减少干扰物等。

Pupil Neon XR:Neon眼动追踪模块 可以为 XR 设备配备由 Neon 提供支持的研究级眼动追踪功能,并提供高度准确的眼动追踪数据。

技术参数 | |

眼动追踪技术 | 实时神经网络 |

双目眼球追踪 | 支持 |

校准 | 无需校准 |

滑点补偿 | 滑移不变 深度学习驱动 |

准确性 | 未校准时:1.8度 1.3度(带偏移校正) |

眼部相机 | 2个红外摄像头 192x192@200Hz |

惯性测量单元 | 加速度计、磁力计、陀螺仪 |

麦克风 | 支持(立体声麦克风) |

实时数据 | 场景相机坐标中的2D注视点,频率为200Hz、110Hz的完整头部姿势、加速度计和陀螺仪数据 红外眼部视频显示,200Hz频率下眼部区域融合 |

事后数据 | 注视和眨眼数据 瞳孔测量数据和眼部状态 |

软件 | 实时:Neon Companion App Unity:Neon XR包 |

实验一般会招募一组具有不同背景的参与者(如初学者与专家)来测试不同的交互方式。

研究任务通常包括目标选择、物体操控、虚拟导航等,设计这些任务的目的是评估不同交互方式的准确性、速度和用户体验。

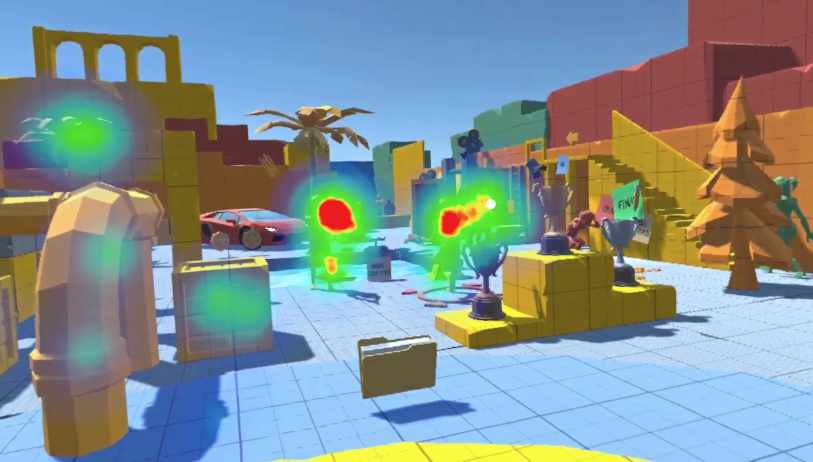

通过眼动追踪器实时记录用户的视线路径、停留时间、注视点移动等数据。这些数据随后会与用户的任务表现(如错误率、完成时间)进行关联分析。为了确保数据的可靠性,实验通常会重复多次测量并采用多种统计分析方法。

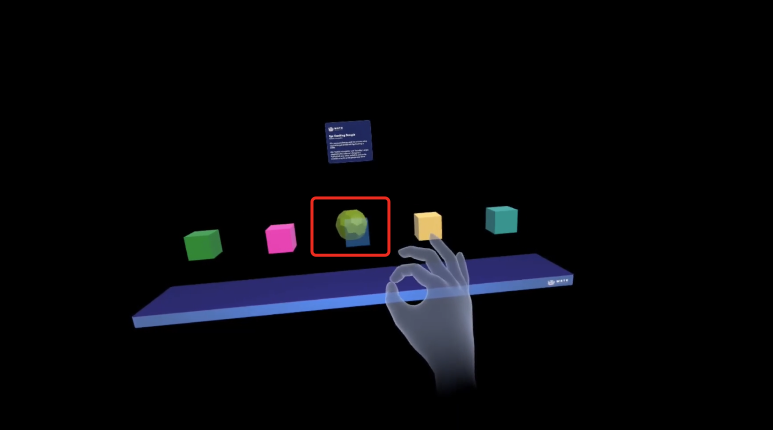

演示中,用户正在查看环境中的物体并使用捏合手势进行交互。

在 XR 环境中运行视觉行为分析实验。

除了定量数据,用户的主观感受也至关重要。实验后通常会进行问卷调查或访谈,以了解用户对不同交互方式的体验感受,包括是否感到自然、是否易于学习、疲劳感等。

对比实验与结果验证: 许多研究通过对比实验来验证凝视交互的效果,如将眼动控制与传统的手柄、语音控制进行比较,评估不同方法在准确性、速度和用户满意度方面的差异。

在多个实验研究中,研究者们发现以下一些关键结论:

与头部控制或手持控制器相比,凝视交互通常在选择目标的速度上占优,但在准确性方面有时不如头部控制,尤其是在需要细微调整的场景中。

例如,有研究发现,眼动交互在小目标选择任务中可能出现“米达斯触摸”[Midas Touch]问题,即用户无意中触发了交互。这表明尽管凝视交互具有速度优势,但仍需通过技术优化(如加入手势确认或其他辅助操作)来提高其准确性和稳定性。

眼动追踪为理解用户的注意力和意图提供了新的途径,能够实时适应用户的需求。

例如,一些研究通过眼动数据动态调整虚拟内容的显示位置或分辨率,使重要信息始终处于用户的视线中央。然而,眼动追踪的准确性仍受到设备性能、光线变化、用户佩戴姿势等因素的影响。因此,如何提升眼动追踪的精度与鲁棒性,仍是未来研究的重要方向。

许多实验表明,眼动交互与其他输入方式(如手势、语音)结合,可以显著提升用户体验。

例如,用户通过视线锁定目标,然后使用手势进行操控或语音确认,这样可以避免单一交互方式带来的局限性。这种多模态的协同效应为未来的XR交互设计提供了更多可能。

实验结果显示,长时间使用凝视交互可能导致眼部疲劳,尤其是在需要频繁注视或凝视停留的任务中。相比之下,结合手势或语音等多模态输入的方式,能够在一定程度上缓解这种疲劳感。

此外,适当的视觉引导(如动态调整内容位置)也能减轻用户的视觉负担,提高整体的舒适性。

参考文献

[1] Vijay Rajanna and John Paulin Hansen. 2018. Gaze typing in virtual reality: Impact of keyboard design, selection method, and motion. In Proceedings of the ACM Symposium on Eye Tracking Research & Applications. Article 15, 10 pages.

[2] Mohamed Khamis, Carl Oechsner, Florian Alt, and Andreas Bulling. 2018. VRpursuits: Interaction in virtual reality using smooth pursuit eye movements. In Proceedings of the International Conference on Advanced Visual Interfaces. Article 18, 8 pages.

[3] Takumi Toyama, Jason Orlosky, Daniel Sonntag, and Kiyoshi Kiyokawa. 2014. A natural interface for multi-focal plane head mounted displays using 3D gaze. In Proceedings of the International Working Conference on Advanced Visual Interfaces. 25–32.

[4] Jae-Young Lee, Hyung-Min Park, Seok-Han Lee, Tae-Eun Kim, and Jong-Soo Choi. 2011. Design and implementation of an augmented reality system using gaze interaction. In Proceedings of the International Conference on Information Science and Applications. 1–8.

[5] Thammathip Piumsomboon, Gun Lee, Robert W. Lindeman, and Mark Billinghurst. 2017. Exploring natural eye-gaze-based interaction for immersive virtual reality. In Proceedings of the IEEE Symposium on 3D User Interfaces. 36–39.

[6] Mihai Bâce, Teemu Leppänen, David Gil De Gomez, and Argenis Ramirez Gomez. 2016. UbiGaze: Ubiquitous augmented reality messaging using gaze gestures. In Proceedings of the SIGGRAPH Asia Mobile Graphics and Interactive Applications. Article 11, 5 pages.

[7] Ken Pfeuffer, Benedikt Mayer, Diako Mardanbegi, and Hans Gellersen. 2017. Gaze + pinch interaction in virtual reality. In Proceedings of the Symposium on Spatial User Interaction. 99–108.

[8] Ann McNamara, Chethna Kabeerdoss, and Conrad Egan. 2015. Mobile user interfaces based on user attention. In Proceedings of the Workshop on Future Mobile User Interfaces. 1–3.

[9] Takumi Toyama, Daniel Sonntag, Jason Orlosky, and Kiyoshi Kiyokawa. 2015. Attention engagement and cognitive state analysis for augmented reality text display functions. In Proceedings of the International Conference on Intelligent User Interfaces. 322–332.

[10] David Lindlbauer, Anna Maria Feit, and Otmar Hilliges. 2019. Context-aware online adaptation of mixed reality interfaces. In Proceedings of the Annual ACM Symposium on User Interface Software and Technology. 147–160.

[11] Sven Seele, Sebastian Misztal, Helmut Buhler, Rainer Herpers, and Jonas Schild. 2017. Here’s looking at you anyway! How important is realistic gaze behavior in co-located social virtual reality games? In Proceedings of the Annual Symposium on Computer-Human Interaction in Play. 531–540.

[12] David Roberts, Robin Wolff, John Rae, Anthony Steed, Rob Aspin, Moira McIntyre, Adriana Pena, Oyewole Oyekoya, and William Steptoe. 2009. Communicating eye-gaze across a distance: Comparing an eye-gaze enabled immersive collaborative virtual environment, aligned video conferencing, and being together. In Proceedings of the IEEE Virtual Reality Conference. 135–142.

[13] Nahal Norouzi, Austin Erickson, Kangsoo Kim, Ryan Schubert, Joseph J. LaViola Jr., Gerd Bruder, and Gregory F. Welch. 2019. Effects of shared gaze parameters on visual target identification task performance in augmented reality. In Proceedings of the ACM Symposium on Spatial User Interaction. 1–11.

[14] Andrei State. 2007. Exact eye contact with virtual humans. In Proceedings of the International Workshop on Human-Computer Interaction. 138–145.

[15] William Steptoe, Anthony Steed, Aitor Rovira, and John Rae. 2010. Lie tracking: Social presence, truth and deception in avatar-mediated telecommunication. In Proceedings of the SIGCHI Conference on Human Factors in Computing Systems. 1039–1048.

(全文结束)

部分素材源于网络

如有侵权,请联系删除